さくらのクラウドでUnixBenchとiops を計測した。ついでに、さくらのVPS SSDプランと比較してみました。

以前、

- さくらのVPS の SSD 1Gプランが出たので、UnixBench と iops を計測してみました。ついでに、お名前.com VPS(KVM) 1Gプランとも比較してみました。

- さくらのVPS の SSD 1Gプランが出たので、iops を計測してみました。ついでに、お名前.com VPS(KVM) 1Gプランとも比較してみました。(2)

で、さくらのVPSのSSDプランについて、UnixBnech, iops を計測してみました。

今回は、さくらのクラウドで、同じようにUnixBnech, iops を計測してみました。

Input/Output Per Second の略で、簡単に言うと時間あたりの読み書き量を表す単位のことです。

ハードディスクなどの記憶装置の性能指標の一つで、ある条件の元で1秒間に読み込み・書き込みできる回数のことです。

1回の読み書きにかかる時間の逆数で、ハードディスクの場合はシークタイムと回転待ち時間、データ転送時間の和の逆数となります。 実際には、読み込み(リード)か書き込み(ライト)か、シーケンシャルアクセスかランダムアクセスか、 転送するデータの量がどれくらいかによって1回の動作に要する時間が異なるため、「4KBランダムライトIOPS」(4KBのデータをランダムに書き込んだ時のIOPS)のように計測条件を明示することが多いです。

(出典 : http://e-words.jp

latencyのことで、直訳すると「遅延」という意味になります。

データ転送において、データを要求してから実際に送られてくるまでの待ち時間のことです。この時間が短いほどシステム全体の処理性能は高くなります。

(出典 : http://e-words.jp

OS : CentOS 6.3 (デフォルトOS)

さくらのクラウド :CPU 1コア メモリ 1G プラン SSD 20GB

さくらのVPS :SSD 1G プラン (北海道(石狩データセンター))

- 目次

- 履歴

2013.11.15 初版

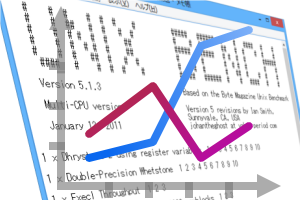

UnixBenchの実施結果

-

さくらのクラウドCPU 1コア メモリ 1G プランでのUnixBenchの実施結果

データセンターは、北海道(石狩)です。

# # # # # # # ##### ###### # # #### # # # # ## # # # # # # # ## # # # # # # # # # # # ## ##### ##### # # # # ###### # # # # # # ## # # # # # # # # # # # # ## # # # # # # # ## # # # # #### # # # # # ##### ###### # # #### # # Version 5.1.3 Based on the Byte Magazine Unix Benchmark Multi-CPU version Version 5 revisions by Ian Smith, Sunnyvale, CA, USA January 13, 2011 johantheghost at yahoo period com 1 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10 1 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10 1 x Execl Throughput 1 2 3 1 x File Copy 1024 bufsize 2000 maxblocks 1 2 3 1 x File Copy 256 bufsize 500 maxblocks 1 2 3 1 x File Copy 4096 bufsize 8000 maxblocks 1 2 3 1 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10 1 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10 1 x Process Creation 1 2 3 1 x System Call Overhead 1 2 3 4 5 6 7 8 9 10 1 x Shell Scripts (1 concurrent) 1 2 3 1 x Shell Scripts (8 concurrent) 1 2 3 ======================================================================== BYTE UNIX Benchmarks (Version 5.1.3) System: suta: GNU/Linux OS: GNU/Linux -- 2.6.32-358.2.1.el6.x86_64 -- #1 SMP Wed Mar 13 00:26:49 UTC 2013 Machine: x86_64 (x86_64) Language: en_US.utf8 (charmap="UTF-8", collate="UTF-8") CPU 0: Intel(R) Xeon(R) CPU E5-2640 0 @ 2.50GHz (5000.0 bogomips) x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET 16:01:31 up 37 min, 1 user, load average: 7.67, 4.38, 2.08; runlevel 3 ------------------------------------------------------------------------ Benchmark Run: Thu Nov 14 2013 16:01:31 - 16:29:22 1 CPU in system; running 1 parallel copy of tests Dhrystone 2 using register variables 31260389.8 lps (10.0 s, 7 samples) Double-Precision Whetstone 1851.5 MWIPS (10.0 s, 7 samples) Execl Throughput 4747.1 lps (30.0 s, 2 samples) File Copy 1024 bufsize 2000 maxblocks 1027328.9 KBps (30.0 s, 2 samples) File Copy 256 bufsize 500 maxblocks 291583.0 KBps (30.0 s, 2 samples) File Copy 4096 bufsize 8000 maxblocks 2020009.6 KBps (30.0 s, 2 samples) Pipe Throughput 2007731.1 lps (10.0 s, 7 samples) Pipe-based Context Switching 354515.9 lps (10.0 s, 7 samples) Process Creation 15170.9 lps (30.0 s, 2 samples) Shell Scripts (1 concurrent) 5571.5 lpm (60.0 s, 2 samples) Shell Scripts (8 concurrent) 745.8 lpm (60.0 s, 2 samples) System Call Overhead 2500157.8 lps (10.0 s, 7 samples) System Benchmarks Index Values BASELINE RESULT INDEX Dhrystone 2 using register variables 116700.0 31260389.8 2678.7 Double-Precision Whetstone 55.0 1851.5 336.6 Execl Throughput 43.0 4747.1 1104.0 File Copy 1024 bufsize 2000 maxblocks 3960.0 1027328.9 2594.3 File Copy 256 bufsize 500 maxblocks 1655.0 291583.0 1761.8 File Copy 4096 bufsize 8000 maxblocks 5800.0 2020009.6 3482.8 Pipe Throughput 12440.0 2007731.1 1613.9 Pipe-based Context Switching 4000.0 354515.9 886.3 Process Creation 126.0 15170.9 1204.0 Shell Scripts (1 concurrent) 42.4 5571.5 1314.0 Shell Scripts (8 concurrent) 6.0 745.8 1242.9 System Call Overhead 15000.0 2500157.8 1666.8 ======== System Benchmarks Index Score 1431.9

-

さくらのVPS SSD 1GプランでのUnixBenchの実施結果

データセンターは、北海道(石狩)です。

# # # # # # # ##### ###### # # #### # # # # ## # # # # # # # ## # # # # # # # # # # # ## ##### ##### # # # # ###### # # # # # # ## # # # # # # # # # # # # ## # # # # # # # ## # # # # #### # # # # # ##### ###### # # #### # # Version 5.1.3 Based on the Byte Magazine Unix Benchmark Multi-CPU version Version 5 revisions by Ian Smith, Sunnyvale, CA, USA January 13, 2011 johantheghost at yahoo period com 1 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10 1 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10 1 x Execl Throughput 1 2 3 1 x File Copy 1024 bufsize 2000 maxblocks 1 2 3 1 x File Copy 256 bufsize 500 maxblocks 1 2 3 1 x File Copy 4096 bufsize 8000 maxblocks 1 2 3 1 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10 1 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10 1 x Process Creation 1 2 3 1 x System Call Overhead 1 2 3 4 5 6 7 8 9 10 1 x Shell Scripts (1 concurrent) 1 2 3 1 x Shell Scripts (8 concurrent) 1 2 3 2 x Dhrystone 2 using register variables 1 2 3 4 5 6 7 8 9 10 2 x Double-Precision Whetstone 1 2 3 4 5 6 7 8 9 10 2 x Execl Throughput 1 2 3 2 x File Copy 1024 bufsize 2000 maxblocks 1 2 3 2 x File Copy 256 bufsize 500 maxblocks 1 2 3 2 x File Copy 4096 bufsize 8000 maxblocks 1 2 3 2 x Pipe Throughput 1 2 3 4 5 6 7 8 9 10 2 x Pipe-based Context Switching 1 2 3 4 5 6 7 8 9 10 2 x Process Creation 1 2 3 2 x System Call Overhead 1 2 3 4 5 6 7 8 9 10 2 x Shell Scripts (1 concurrent) 1 2 3 2 x Shell Scripts (8 concurrent) 1 2 3 ======================================================================== BYTE UNIX Benchmarks (Version 5.1.3) System: www2123gi.sakura.ne.jp: GNU/Linux OS: GNU/Linux -- 2.6.32-279.14.1.el6.x86_64 -- #1 SMP Tue Nov 6 23:43:09 UTC 2012 Machine: x86_64 (x86_64) Language: en_US.utf8 (charmap="UTF-8", collate="UTF-8") CPU 0: Intel(R) Xeon(R) CPU E5-2640 (5000.0 bogomips) Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSCALL/SYSRET CPU 1: Intel(R) Xeon(R) CPU E5-2640 (5000.0 bogomips) Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSCALL/SYSRET 15:53:53 up 1:15, 1 user, load average: 13.60, 7.26, 3.84; runlevel 3 ------------------------------------------------------------------------ Benchmark Run: Thu Dec 13 2012 15:53:53 - 16:22:05 2 CPUs in system; running 1 parallel copy of tests Dhrystone 2 using register variables 27434596.8 lps (10.0 s, 7 samples) Double-Precision Whetstone 2926.2 MWIPS (9.9 s, 7 samples) Execl Throughput 3291.6 lps (30.0 s, 2 samples) File Copy 1024 bufsize 2000 maxblocks 858663.8 KBps (30.0 s, 2 samples) File Copy 256 bufsize 500 maxblocks 244322.5 KBps (30.0 s, 2 samples) File Copy 4096 bufsize 8000 maxblocks 987902.9 KBps (30.0 s, 2 samples) Pipe Throughput 1674987.9 lps (10.0 s, 7 samples) Pipe-based Context Switching 28124.3 lps (10.0 s, 7 samples) Process Creation 9462.9 lps (30.0 s, 2 samples) Shell Scripts (1 concurrent) 5629.4 lpm (60.0 s, 2 samples) Shell Scripts (8 concurrent) 1234.0 lpm (60.0 s, 2 samples) System Call Overhead 2164618.7 lps (10.0 s, 7 samples) System Benchmarks Index Values BASELINE RESULT INDEX Dhrystone 2 using register variables 116700.0 27434596.8 2350.9 Double-Precision Whetstone 55.0 2926.2 532.0 Execl Throughput 43.0 3291.6 765.5 File Copy 1024 bufsize 2000 maxblocks 3960.0 858663.8 2168.3 File Copy 256 bufsize 500 maxblocks 1655.0 244322.5 1476.3 File Copy 4096 bufsize 8000 maxblocks 5800.0 987902.9 1703.3 Pipe Throughput 12440.0 1674987.9 1346.5 Pipe-based Context Switching 4000.0 28124.3 70.3 Process Creation 126.0 9462.9 751.0 Shell Scripts (1 concurrent) 42.4 5629.4 1327.7 Shell Scripts (8 concurrent) 6.0 1234.0 2056.7 System Call Overhead 15000.0 2164618.7 1443.1 ======== System Benchmarks Index Score 1032.2 ------------------------------------------------------------------------ Benchmark Run: Thu Dec 13 2012 16:22:05 - 16:50:17 2 CPUs in system; running 2 parallel copies of tests Dhrystone 2 using register variables 54628018.3 lps (10.0 s, 7 samples) Double-Precision Whetstone 5844.9 MWIPS (10.0 s, 7 samples) Execl Throughput 7560.1 lps (30.0 s, 2 samples) File Copy 1024 bufsize 2000 maxblocks 958747.7 KBps (30.0 s, 2 samples) File Copy 256 bufsize 500 maxblocks 252624.4 KBps (30.0 s, 2 samples) File Copy 4096 bufsize 8000 maxblocks 1834520.1 KBps (30.0 s, 2 samples) Pipe Throughput 3335408.1 lps (10.0 s, 7 samples) Pipe-based Context Switching 557364.9 lps (10.0 s, 7 samples) Process Creation 24365.1 lps (30.0 s, 2 samples) Shell Scripts (1 concurrent) 9341.7 lpm (60.0 s, 2 samples) Shell Scripts (8 concurrent) 1261.5 lpm (60.0 s, 2 samples) System Call Overhead 3371725.7 lps (10.0 s, 7 samples) System Benchmarks Index Values BASELINE RESULT INDEX Dhrystone 2 using register variables 116700.0 54628018.3 4681.1 Double-Precision Whetstone 55.0 5844.9 1062.7 Execl Throughput 43.0 7560.1 1758.2 File Copy 1024 bufsize 2000 maxblocks 3960.0 958747.7 2421.1 File Copy 256 bufsize 500 maxblocks 1655.0 252624.4 1526.4 File Copy 4096 bufsize 8000 maxblocks 5800.0 1834520.1 3163.0 Pipe Throughput 12440.0 3335408.1 2681.2 Pipe-based Context Switching 4000.0 557364.9 1393.4 Process Creation 126.0 24365.1 1933.7 Shell Scripts (1 concurrent) 42.4 9341.7 2203.2 Shell Scripts (8 concurrent) 6.0 1261.5 2102.5 System Call Overhead 15000.0 3371725.7 2247.8 ======== System Benchmarks Index Score 2107.8

iopsの計測方法

iopsの計測には、さくらインターネットで計測されているものと同じ fio コマンドを使用し、そのパラメータを以下のように指定しました。(パラメータもさくらインターネットで計測されたものと同じです。)

fioコマンドのインストール

まずは、fioコマンドのインストールします。

- fioコマンドの最新ファイルをダウンロードする。

$ wget http://freecode.com/urls/3aa21b8c106cab742bf1f20d60629e3f -O fio.tar.gz ...

現在の最新バージョンが、2.1.10 だったので、そのバージョンをダウンロードしてみました。

...

現在の最新バージョンが、2.1.10 だったので、そのバージョンをダウンロードしてみました。

最新バージョンは、 http://freecode.com/projects/fio/で確認しましょう。適当なディレクトリで解凍しておきます。

$ tar xfz fio.tar.gz ...

...

- fioをコンパイルする。

fioをコンパイルするには、makeおよびgcc、libaioが必要になります。

前準備として以下のツールをインストールします。CentOS/ScientificLinux の場合

$ yum -y install make gcc libaio-devel ...

...

Debian/Ubuntu の場合

$ apt-get -y install make gcc perl libaio-dev ...

...

準備を終えたら、続けてmakeを実行します。

実行するディレクトリは、先にfioを解凍したディレクトリで実行します。$ cd fio-2.1.10 [fio-2.1.10]$ make

[fio-2.1.10]$ make ...

...

ここでエラーがでない場合は、インストールします。

[fio-2.1.10]$ make install install -m 755 -d /usr/local/bin

...

install -m 755 -d /usr/local/bin

...

fioコマンドが使えるか確認します。

[fio-2.1.10]$ fio --version fio-2.1.10

fio-2.1.10

fioコマンドのパラメータ設定ファイル作成

さくらインターネットで計測されたfio コマンドのパラメータは、以下のように指定したそうです。

以下は、さくらインターネットで計測された際の fioコマンドのパラメータ設定ファイルになります。

- 書き込みパフォーマンスを確認したfioパラメータ設定ファイル

ファイル名:randwrite.fio

[global] ioengine=libaio direct=1 invalidate=1 group_reporting directory=/home filename=test.bin runtime=60 [Rand-Write-4k-qd32] readwrite=randwrite size=4G bs=4k iodepth=32 numjobs=1

- 読み込みパフォーマンスを確認したfioパラメータ設定ファイル

ファイル名:randread.fio

[global] ioengine=libaio direct=1 invalidate=1 group_reporting directory=/home filename=test.bin runtime=60 [Rand-Read-4k-qd32] readwrite=randread size=4G bs=4k iodepth=32 numjobs=1

[ fioパラメータの意味 ]

- libaio : Linuxネイティブの非同期I/O

- read : Sequential reads.

- write : Sequential writes.

- randread : Random reads.

- randwrite : Random writes.

- rw : Mixed sequential reads and writes.

- randrw : Mixed random reads and writes.

|

fio 実行結果(iops,レイテンシ)

-

さくらのクラウドCPU 1コア メモリ 1G プランでのfio 実行結果(iops,レイテンシ)

データセンターは、北海道(石狩)です。

- 読み込み(read)の実行結果

# fioでテスト用に作成されているファイルを削除する $ rm -f /home/test.bin # fioを実行する

$ fio randread.fio

# fioを実行する

$ fio randread.fio Rand-Read-4k-qd32: (g=0): rw=randread, bs=4K-4K/4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio-2.0.13

Starting 1 process

Rand-Read-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Rand-Read-4k-qd32: (groupid=0, jobs=1): err= 0: pid=12745: Thu Nov 14 16:54:05 2013

read : io=1406.6MB, bw=24003KB/s, iops=6000 , runt= 60004msec

slat (usec): min=2 , max=604 , avg=10.08, stdev= 3.23

clat (usec): min=341 , max=62467 , avg=5319.88, stdev=7545.37

lat (usec): min=352 , max=62478 , avg=5330.40, stdev=7545.37

clat percentiles (usec):

| 1.00th=[ 3024], 5.00th=[ 3216], 10.00th=[ 3280], 20.00th=[ 3344],

| 30.00th=[ 3408], 40.00th=[ 3472], 50.00th=[ 3536], 60.00th=[ 3568],

| 70.00th=[ 3664], 80.00th=[ 3760], 90.00th=[ 3984], 95.00th=[34048],

| 99.00th=[38656], 99.50th=[39168], 99.90th=[40192], 99.95th=[40704],

| 99.99th=[48384]

bw (KB/s) : min=22703, max=25560, per=100.00%, avg=24011.22, stdev=200.81

lat (usec) : 500=0.01%, 750=0.03%, 1000=0.03%

lat (msec) : 2=0.12%, 4=92.41%, 10=2.06%, 20=0.02%, 50=5.33%

lat (msec) : 100=0.01%

cpu : usr=2.49%, sys=10.80%, ctx=286349, majf=0, minf=55

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued : total=r=360066/w=0/d=0, short=r=0/w=0/d=0

Run status group 0 (all jobs):

READ: io=1406.6MB, aggrb=24002KB/s, minb=24002KB/s, maxb=24002KB/s, mint=60004msec, maxt=60004msec

Disk stats (read/write):

vda: ios=359891/7, merge=0/2, ticks=1910321/16, in_queue=1910306, util=99.89%

Rand-Read-4k-qd32: (g=0): rw=randread, bs=4K-4K/4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio-2.0.13

Starting 1 process

Rand-Read-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Rand-Read-4k-qd32: (groupid=0, jobs=1): err= 0: pid=12745: Thu Nov 14 16:54:05 2013

read : io=1406.6MB, bw=24003KB/s, iops=6000 , runt= 60004msec

slat (usec): min=2 , max=604 , avg=10.08, stdev= 3.23

clat (usec): min=341 , max=62467 , avg=5319.88, stdev=7545.37

lat (usec): min=352 , max=62478 , avg=5330.40, stdev=7545.37

clat percentiles (usec):

| 1.00th=[ 3024], 5.00th=[ 3216], 10.00th=[ 3280], 20.00th=[ 3344],

| 30.00th=[ 3408], 40.00th=[ 3472], 50.00th=[ 3536], 60.00th=[ 3568],

| 70.00th=[ 3664], 80.00th=[ 3760], 90.00th=[ 3984], 95.00th=[34048],

| 99.00th=[38656], 99.50th=[39168], 99.90th=[40192], 99.95th=[40704],

| 99.99th=[48384]

bw (KB/s) : min=22703, max=25560, per=100.00%, avg=24011.22, stdev=200.81

lat (usec) : 500=0.01%, 750=0.03%, 1000=0.03%

lat (msec) : 2=0.12%, 4=92.41%, 10=2.06%, 20=0.02%, 50=5.33%

lat (msec) : 100=0.01%

cpu : usr=2.49%, sys=10.80%, ctx=286349, majf=0, minf=55

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued : total=r=360066/w=0/d=0, short=r=0/w=0/d=0

Run status group 0 (all jobs):

READ: io=1406.6MB, aggrb=24002KB/s, minb=24002KB/s, maxb=24002KB/s, mint=60004msec, maxt=60004msec

Disk stats (read/write):

vda: ios=359891/7, merge=0/2, ticks=1910321/16, in_queue=1910306, util=99.89%

ちょうど、iops = 6000 となっています。

また、レイテンシの値は、平均 5.33 ms となっています。

下の lat値の分布からすると、おおむね 4ms 前後なので、まあ、先の平均値の処理速度のようです。

- 書き込み(write)の実行結果

# fioでテスト用に作成されているファイルを削除する $ rm -f /home/test.bin # fioを実行する

$ fio randwrite.fio

# fioを実行する

$ fio randwrite.fio Rand-Write-4k-qd32: (g=0): rw=randwrite, bs=4K-4K/4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio-2.0.13

Starting 1 process

Rand-Write-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Rand-Write-4k-qd32: (groupid=0, jobs=1): err= 0: pid=12749: Thu Nov 14 16:55:05 2013

write: io=359520KB, bw=5990.1KB/s, iops=1497 , runt= 60011msec

slat (usec): min=5 , max=12334 , avg=16.70, stdev=115.01

clat (usec): min=415 , max=117247 , avg=21345.73, stdev=31803.33

lat (usec): min=444 , max=117263 , avg=21362.90, stdev=31802.48

clat percentiles (msec):

| 1.00th=[ 4], 5.00th=[ 4], 10.00th=[ 5], 20.00th=[ 5],

| 30.00th=[ 5], 40.00th=[ 5], 50.00th=[ 5], 60.00th=[ 6],

| 70.00th=[ 6], 80.00th=[ 81], 90.00th=[ 83], 95.00th=[ 84],

| 99.00th=[ 85], 99.50th=[ 85], 99.90th=[ 88], 99.95th=[ 89],

| 99.99th=[ 117]

bw (KB/s) : min= 5397, max= 6216, per=100.00%, avg=5993.10, stdev=85.21

lat (usec) : 500=0.01%, 750=0.03%, 1000=0.05%

lat (msec) : 2=0.17%, 4=5.31%, 10=72.62%, 20=0.40%, 50=0.07%

lat (msec) : 100=21.29%, 250=0.03%

cpu : usr=0.55%, sys=2.83%, ctx=65748, majf=0, minf=22

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued : total=r=0/w=89880/d=0, short=r=0/w=0/d=0

Run status group 0 (all jobs):

WRITE: io=359520KB, aggrb=5990KB/s, minb=5990KB/s, maxb=5990KB/s, mint=60011msec, maxt=60011msec

Disk stats (read/write):

vda: ios=5/89982, merge=0/6334, ticks=16/1915278, in_queue=1915527, util=99.84%

Rand-Write-4k-qd32: (g=0): rw=randwrite, bs=4K-4K/4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio-2.0.13

Starting 1 process

Rand-Write-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Rand-Write-4k-qd32: (groupid=0, jobs=1): err= 0: pid=12749: Thu Nov 14 16:55:05 2013

write: io=359520KB, bw=5990.1KB/s, iops=1497 , runt= 60011msec

slat (usec): min=5 , max=12334 , avg=16.70, stdev=115.01

clat (usec): min=415 , max=117247 , avg=21345.73, stdev=31803.33

lat (usec): min=444 , max=117263 , avg=21362.90, stdev=31802.48

clat percentiles (msec):

| 1.00th=[ 4], 5.00th=[ 4], 10.00th=[ 5], 20.00th=[ 5],

| 30.00th=[ 5], 40.00th=[ 5], 50.00th=[ 5], 60.00th=[ 6],

| 70.00th=[ 6], 80.00th=[ 81], 90.00th=[ 83], 95.00th=[ 84],

| 99.00th=[ 85], 99.50th=[ 85], 99.90th=[ 88], 99.95th=[ 89],

| 99.99th=[ 117]

bw (KB/s) : min= 5397, max= 6216, per=100.00%, avg=5993.10, stdev=85.21

lat (usec) : 500=0.01%, 750=0.03%, 1000=0.05%

lat (msec) : 2=0.17%, 4=5.31%, 10=72.62%, 20=0.40%, 50=0.07%

lat (msec) : 100=21.29%, 250=0.03%

cpu : usr=0.55%, sys=2.83%, ctx=65748, majf=0, minf=22

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued : total=r=0/w=89880/d=0, short=r=0/w=0/d=0

Run status group 0 (all jobs):

WRITE: io=359520KB, aggrb=5990KB/s, minb=5990KB/s, maxb=5990KB/s, mint=60011msec, maxt=60011msec

Disk stats (read/write):

vda: ios=5/89982, merge=0/6334, ticks=16/1915278, in_queue=1915527, util=99.84%

こちらは、iops = 1497 となっています。

また、レイテンシの値は、平均 21.362 ms となっています。

下の lat値の分布からすると、10ms ~ 20ms がピークなので、先の平均値は多少悪いデータに引きずられた感じのようです。

そのため、本来のパフォーマンスは、 15 ms あたりではないでしょうか。

- 読み込み(read)の実行結果

-

さくらのVPS SSD 1G プランでのfio 実行結果(iops,レイテンシ)

データセンターは、北海道(石狩)です。

- 読み込み(read)の実行結果

# fioでテスト用に作成されているファイルを削除する $ rm -f /home/test.bin # fioを実行する

$ fio randread.fio

# fioを実行する

$ fio randread.fio Rand-Read-4k-qd32: (g=0): rw=randread, bs=4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio 1.57

Starting 1 process

Rand-Read-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Jobs: 1 (f=1): [r] [100.0% done] [45056K/0K /s] [11.0K/0 iops] [eta 00m:00s]

Rand-Read-4k-qd32: (groupid=0, jobs=1): err= 0: pid=15569

read : io=2575.5MB, bw=43946KB/s, iops=10986 , runt= 60002msec

slat (usec): min=3 , max=1691 , avg=12.47, stdev=12.60

clat (usec): min=97 , max=168887 , avg=2897.21, stdev=13360.41

lat (usec): min=108 , max=168893 , avg=2910.32, stdev=13359.88

bw (KB/s) : min=37472, max=45040, per=100.04%, avg=43964.57, stdev=688.11

cpu : usr=3.47%, sys=15.42%, ctx=10209, majf=0, minf=54

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued r/w/d: total=659211/0/0, short=0/0/0

lat (usec): 100=0.01%, 250=0.91%, 500=25.82%, 750=59.90%, 1000=9.50%

lat (msec): 2=0.91%, 4=0.01%, 10=0.04%, 20=0.01%, 100=2.91%

lat (msec): 250=0.01%

Run status group 0 (all jobs):

READ: io=2575.5MB, aggrb=43945KB/s, minb=45000KB/s, maxb=45000KB/s, mint=60002msec, maxt=60002msec

Disk stats (read/write):

vda: ios=657388/20, merge=0/29, ticks=1721351/352, in_queue=1721327, util=99.86%

Rand-Read-4k-qd32: (g=0): rw=randread, bs=4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio 1.57

Starting 1 process

Rand-Read-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Jobs: 1 (f=1): [r] [100.0% done] [45056K/0K /s] [11.0K/0 iops] [eta 00m:00s]

Rand-Read-4k-qd32: (groupid=0, jobs=1): err= 0: pid=15569

read : io=2575.5MB, bw=43946KB/s, iops=10986 , runt= 60002msec

slat (usec): min=3 , max=1691 , avg=12.47, stdev=12.60

clat (usec): min=97 , max=168887 , avg=2897.21, stdev=13360.41

lat (usec): min=108 , max=168893 , avg=2910.32, stdev=13359.88

bw (KB/s) : min=37472, max=45040, per=100.04%, avg=43964.57, stdev=688.11

cpu : usr=3.47%, sys=15.42%, ctx=10209, majf=0, minf=54

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued r/w/d: total=659211/0/0, short=0/0/0

lat (usec): 100=0.01%, 250=0.91%, 500=25.82%, 750=59.90%, 1000=9.50%

lat (msec): 2=0.91%, 4=0.01%, 10=0.04%, 20=0.01%, 100=2.91%

lat (msec): 250=0.01%

Run status group 0 (all jobs):

READ: io=2575.5MB, aggrb=43945KB/s, minb=45000KB/s, maxb=45000KB/s, mint=60002msec, maxt=60002msec

Disk stats (read/write):

vda: ios=657388/20, merge=0/29, ticks=1721351/352, in_queue=1721327, util=99.86%

しっかり、iops = 10,986 となっていますね。早いです。

また、レイテンシの値は、平均 2.91032 ms となっています。

下の lat値の分布からすると、0.75ms ~ 0.1ms がピークなので、先の平均値は悪いデータに引きずられた感じのようです。

そのため、本来のパフォーマンスは、 0.8 ms あたりではないでしょうか。

- 書き込み(write)の実行結果

# fioでテスト用に作成されているファイルを削除する $ rm -f /home/test.bin # fioを実行する

$ fio randwrite.fio

# fioを実行する

$ fio randwrite.fio Rand-Write-4k-qd32: (g=0): rw=randwrite, bs=4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio 1.57

Starting 1 process

Rand-Write-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Jobs: 1 (f=1): [w] [100.0% done] [0K/44945K /s] [0 /10.1K iops] [eta 00m:00s]

Rand-Write-4k-qd32: (groupid=0, jobs=1): err= 0: pid=15576

write: io=2574.1MB, bw=43944KB/s, iops=10985 , runt= 60002msec

slat (usec): min=0 , max=16667 , avg=16.82, stdev=40.26

clat (usec): min=183 , max=80248 , avg=2894.06, stdev=9121.15

lat (usec): min=202 , max=80270 , avg=2911.28, stdev=9120.80

bw (KB/s) : min=41040, max=45664, per=100.05%, avg=43965.11, stdev=556.86

cpu : usr=2.43%, sys=20.76%, ctx=42075, majf=0, minf=21

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued r/w/d: total=0/659177/0, short=0/0/0

lat (usec): 250=0.01%, 500=2.71%, 750=14.08%, 1000=15.38%

lat (msec): 2=56.14%, 4=7.44%, 10=1.21%, 20=0.14%, 50=0.21%

lat (msec): 100=2.70%

Run status group 0 (all jobs):

WRITE: io=2574.1MB, aggrb=43943KB/s, minb=44998KB/s, maxb=44998KB/s, mint=60002msec, maxt=60002msec

Disk stats (read/write):

vda: ios=0/659517, merge=0/27755, ticks=0/1787891, in_queue=1787503, util=99.70%

Rand-Write-4k-qd32: (g=0): rw=randwrite, bs=4K-4K/4K-4K, ioengine=libaio, iodepth=32

fio 1.57

Starting 1 process

Rand-Write-4k-qd32: Laying out IO file(s) (1 file(s) / 4096MB)

Jobs: 1 (f=1): [w] [100.0% done] [0K/44945K /s] [0 /10.1K iops] [eta 00m:00s]

Rand-Write-4k-qd32: (groupid=0, jobs=1): err= 0: pid=15576

write: io=2574.1MB, bw=43944KB/s, iops=10985 , runt= 60002msec

slat (usec): min=0 , max=16667 , avg=16.82, stdev=40.26

clat (usec): min=183 , max=80248 , avg=2894.06, stdev=9121.15

lat (usec): min=202 , max=80270 , avg=2911.28, stdev=9120.80

bw (KB/s) : min=41040, max=45664, per=100.05%, avg=43965.11, stdev=556.86

cpu : usr=2.43%, sys=20.76%, ctx=42075, majf=0, minf=21

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued r/w/d: total=0/659177/0, short=0/0/0

lat (usec): 250=0.01%, 500=2.71%, 750=14.08%, 1000=15.38%

lat (msec): 2=56.14%, 4=7.44%, 10=1.21%, 20=0.14%, 50=0.21%

lat (msec): 100=2.70%

Run status group 0 (all jobs):

WRITE: io=2574.1MB, aggrb=43943KB/s, minb=44998KB/s, maxb=44998KB/s, mint=60002msec, maxt=60002msec

Disk stats (read/write):

vda: ios=0/659517, merge=0/27755, ticks=0/1787891, in_queue=1787503, util=99.70%

こちらも、iops = 10,985 と 10,000超えです。

また、レイテンシの値は、平均 2.91128 ms となっています。

下の lat値の分布からすると、2 ms ~ 4 ms がピークなので、先の平均値は、まあまあそれぐらいの値に収まっている感じです。

- 読み込み(read)の実行結果

最後にまとめ

| 項目 | さくらのVPS SSD 2G | さくらのクラウド SSD 1G | |

|---|---|---|---|

| UnixBench | 1コア | 1032.2 | 1431.9 |

| 2コア | 2107.8 | – | |

| IOPS | ランダムリード | 10,986 [ 10,000 ] | 6,000 [ 6,000 ] |

| ランダムライト | 10,985 [ 10,000 ] | 1,497 [ – ] | |

| レイテンシ | ランダムリード | 0.75 (ms) [ 0.26 (ms) ] | 4 (ms) [ 0.3 (ms) ] |

| ランダムライト | 2 (ms) [ 0.12 (ms) ] | 1 (ms) [ – ] | |

[]内数値は、さくらインターネットで公開されているデータです。

また、最近では、メモリ16GBのSSDプランまで登場しました。すごいですね。

上記のさくらのVPSのSSDプランのデータは、その当時 メモリ 1G の時のデータなので、今なら、もう少し良い数値が出るかもしれません。

古いデータだと考慮せずとも、

やっぱり、なんだかんだでコストパフォーマンスが良いのは さくらのVPS なんですね。

さくらのVPSに興味のある方は、以下からのどうぞ。お試し期間がありますから、しっかりパフォーマンスをチェックしましょう。

さくらのVPSは、http://vps.sakura.ad.jp/![]() からどうぞ。

からどうぞ。

このサイトでは、コンテンツの一部が非表示、あるいは、コメント、お問い合わせの投稿ができない、検索ができないことがあります。

)

)

コメントを投稿 :